Французская компания Mistral AI, основанная выходцами из Google DeepMind и Meta

Вы не можете просматривать ссылку пожалуйста воспользуйтесь следующими ссылками Вход или Регистрация

, представила компактную модель искусственного интеллекта

Вы не можете просматривать ссылку пожалуйста воспользуйтесь следующими ссылками Вход или Регистрация

— она распространяется с открытым кодом и предлагает высокую производительность.Mistral Small 3 имеет 24 млрд параметров и позиционируется как прямой конкурент более крупным моделям, в том числе Meta

Вы не можете просматривать ссылку пожалуйста воспользуйтесь следующими ссылками Вход или Регистрация

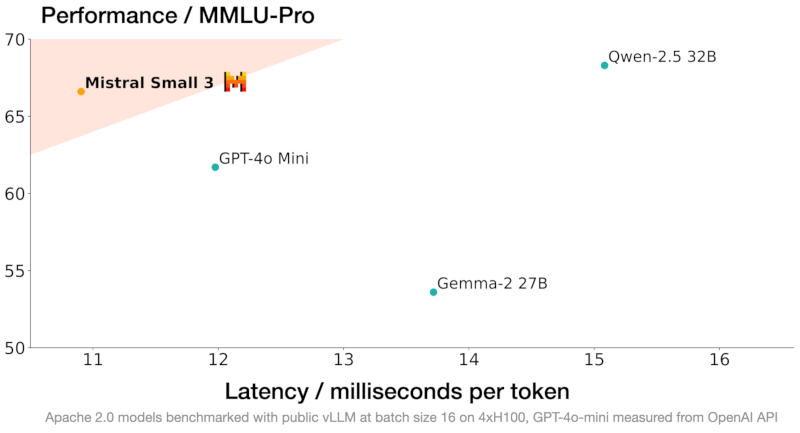

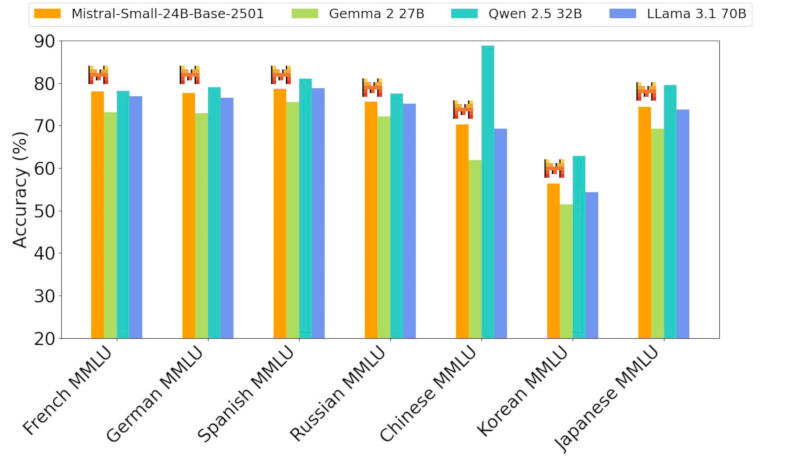

Llama 3.3 70B и Alibaba Qwen 32B, а также как бесплатная замена закрытым системам, включая OpenAI GPT-4o mini. Разработчик уверяет, что новая модель выдаёт результаты на одном уровне с Llama 3.3 70B instruct, но работает втрое быстрее на том же оборудовании, и рассчитана она на 80 % задач генеративного ИИ.

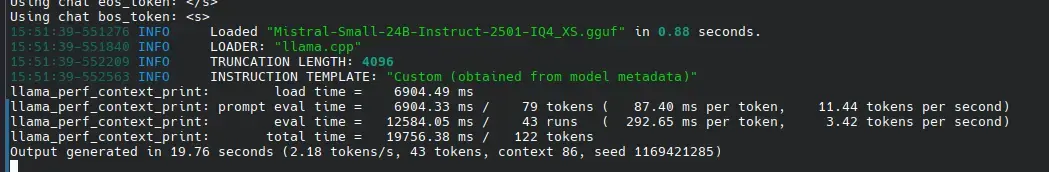

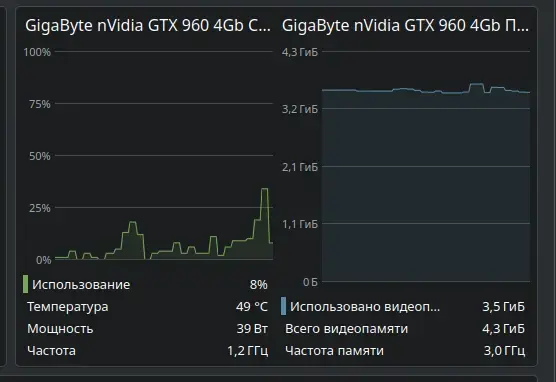

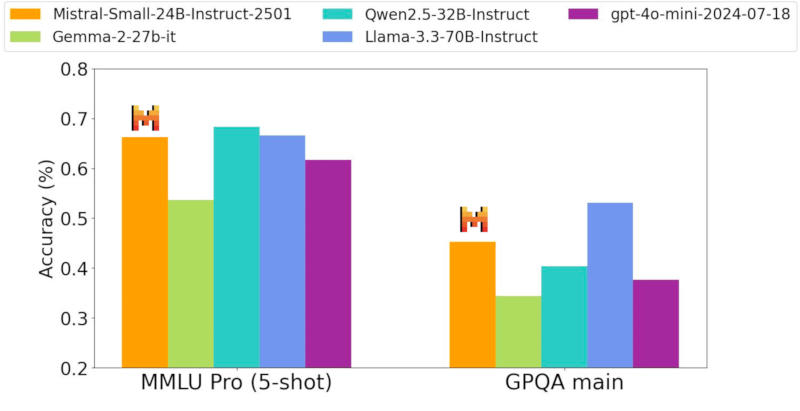

Система создана с прицелом на локальное развёртывание — её архитектура имеет значительно меньше слоёв в сравнении с конкурирующими моделями, что сокращает время на прямой проход. Точность Mistral Small 3 в тесте MMLU составляет 81 % при задержке 150 токенов в секунду, что, как утверждает разработчик, делает её самой эффективной в своей категории. Она также может послужить основой для создания более сложных рассуждающих моделей, таких как DeepSeek R1.

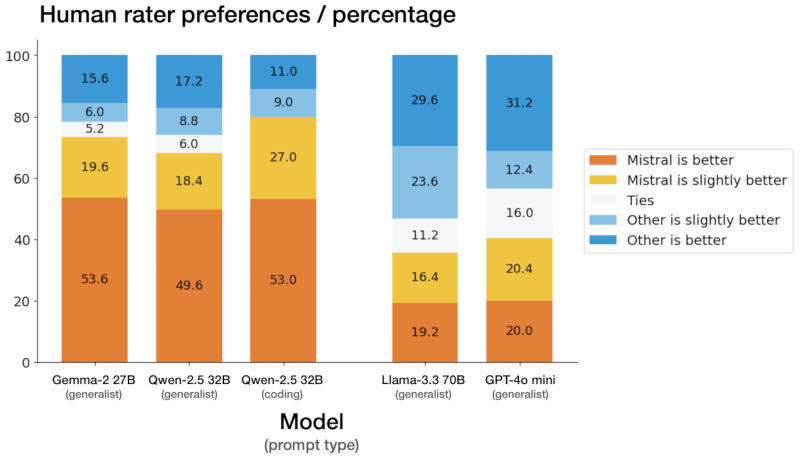

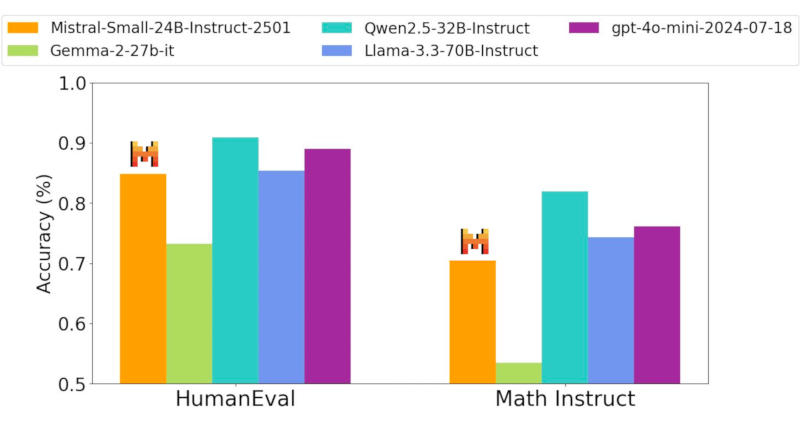

Новая нейросеть прошла тестирование вслепую у сторонних подрядчиков — процедура включала более тысячи заданий на написание кода и ответов на общие вопросы. Mistral Small 3 выдала конкурентоспособные результаты в сравнении с открытыми моделями втрое большего размера, а также закрытой GPT-4o mini в испытаниях, связанных с написанием кода, решением математических задач, проверки общих знаний и выполнения инструкций.

На практике модель окажется полезной в тех случаях, когда критически важны быстрые и точные ответы — это могут быть работающие в реальном времени виртуальные помощники, ИИ-агенты и системы автоматизации рабочих процессов. Разработчик предусмотрел для пользователей возможность проводить тонкую настройку Mistral Small 3 для её специализации в определённых областях — это могут быть юридические консультации, медицинская диагностика и техническая поддержка.

В сфере медицинских услуг Mistral Small 3 способна выявлять попытки мошенничества; в медицине — направлять пациентов к нужным специалистам; в робототехнике, автопроме и на производстве — осуществлять функции управления и контроля; предусмотрены сценарии виртуального обслуживания клиентов, анализа настроений и отзывов. Её можно запустить на системе с одной видеокартой Nvidia GeForce RTX 4090 или на актуальном Apple MacBook с 32 Гбайт оперативной памяти.

Mistral Small 3 уже доступна и в ближайшее время появится на всех наиболее крупных профильных платформах — она распространяется по бесплатной и открытой лицензии Apache 2.0.

Источник:

-

Вы не можете просматривать ссылку пожалуйста воспользуйтесь следующими ссылками Вход или Регистрация